“O OLHAR DOS ESPECIALISTAS DA SET”

Nº 151 – Junho 2015

NAB 2015

A partir desta edição mostraremos o que os 20 especialistas convidados pela SET viram na maior exposição da indústria, a NAB 2015. Teremos textos sobre 8K, 4K, cloud, estruturas IP, drones, transmídia, neutralidade na rede, entre outros.

A Revista da SET convocou alguns dos seus associados para realizar uma série de artigos de opinião que começamos a publicar nesta edição, mostrando como profissionais brasileiros viveram o frenesi da exposição e olharam para os principais lançamentos da indústria.

O intuito da Revista é levar ao seu leitor não só o olhar jornalístico do evento, senão também o olhar profissional de quem vai até Las Vegas para pesquisar, analisar e visualizar os equipamentos e soluções que podem ser úteis na infraestrutura da sua empresa, na sua vida profissional ou para ver que estão fazendo os seus provedores tentando vislumbrar o que fazer no futuro próximo.

Nesta edição, publicamos uma análise académica minuciosa sobre o fenómeno do 8K produzida pelo Professor da ECA/USP, Almir Almas, que esta acompanhada por uma reflexão de Fernando Moura (Revista da SET) sobre o paradigma 4K; um texto sobre receptores AM desenvolvido por Ronald Barbosa (MSc/ABRA); Paulo Guedes Esperante (SBT) debruçando-se sobre diversos temas que tem a ver com a implantação de transmissões 4K (UHD); Paulo Canno (TV Gazeta) explicando o fenômeno das soluções “in cloud”; e finalmente, uma análise sobre a neutralidade na rede escrita por Ioma Carvalho da TV Globo.

“O OLHAR DOS ESPECIALISTAS DA SET”

Televisão do Futuro. NHK e o Super Hi-Vision

A partir desta edição mostraremos o que os 20 especialistas convidados pela SET viram na maior exposição da indústria, a NAB 2015. Teremos textos sobre 8K, 4K, cloud, estruturas IP, drones, transmídia, neutralidade na rede, entre outros.

Quando completava setenta anos, em 1995, a NHK (Nihoon Hoosoo Kyokai), rede pública de televisão japonesa, lançou um documento de perspectivas para o século XXI e ações para os dez anos seguintes, em que se projetava o futuro da televisão e o que essa rede faria a cada ano para concretizarem essa projeção nesse espaço de tempo.

Um dos pontos principais desse planejamento de dez anos era a concretização comercial do ISDB (Integrated Services Digital Broadcasting), descrito como uma avançada tecnologia digital que, pelo que essa tecnologia ofereceria ao meio televisivo, viria popularizar a Hi-vision (até então a TV de Alta Definição japonesa) e possibilitaria à NHK alcançar seu objetivo de “introduzir a digitalização em toda forma de transmissão”. Em duas entrevistas realizadas por mim com o então diretor- adjunto de Relações Públicas da NHK, Shoda Koichiro (uma publicada pela Revista Tela Viva, em 1994 [Tela Viva, no. 29] e a outra, feita em 1995, inédita), este descreve o andamento das pesquisas de transmissão digital que a NHK estava realizando e apontava que a entrada no século XXI traria a concretização do ISDB, que, naqueles planos seria implantado internacionalmente em 2007. (ALMAS, Almir, p. 76-77).(1)

De lá pra cá já se passaram mais vinte anos. E desde o desligamento do sinal analógico (switch-off) naquele país, que se deu em 2011, a NHK vem de novo projetando o que serão seus vinte anos futuros. Em seu planejamento, a NHK dividiu esses próximos vinte anos por etapas com os avanços tecnológicos da televisão digital, sendo que a primeira etapa seria dos próximos três anos, a segunda etapa dos próximos dez anos e a terceira etapa dos próximos vinte anos. A primeira etapa se configuraria com a concretização do chamado Hybricast (ou broadcast híbrido), que teve seu lançamento comercial em 2013. A segunda etapa prevê a consolidação das pesquisas do Super Hi-Vision, a televisão em 8K de resolução de imagem (33 megapixels) e som em 22.2 multicanais. A terceira etapa viria com o lançamento da televisão em 3D em imagem espacial; isto é, da Free 3D TV, imagens em 3D sem óculos especiais. (ALMAS, Almir, p. 226-227).(2)

Esse preâmbulo foi para mostrar que a NHK costuma projetar suas pesquisas de evolução tecnológica da televisão dentro de uma linha de planejamento estratégico em que cada avanço técnico abre e prepara o campo para o seguinte, acumulando conhecimentos e desenvolvimentos, visando atingir um ponto colocado no futuro. No entanto, esse ponto limite nunca é de fato atingido, pois, ao se concretizarem as etapas previstas em seu planejamento temporal, a NHK de imediato prepara novas etapas, novas projeções, levando o ponto a ser atingido mais longe no tempo e mais avançado no estágio tecnológico.

No estande da NHK, no pavilhão do Futuro da NAB 2015, se mostraram diferentes opções de câmeras 8K, esta uma câmera compacta 120Hz

Em síntese, as pesquisas da NHK, desde o começo das primeiras indagações para o estudo da HDTV, em 1964, buscam colocar o telespectador em uma situação de sensação de imersão e de realidade. Na história, o desenvolvimento da televisão de alta definição e, consequentemente, da televisão digital, no Japão, se deu na esteira dessa busca da sensação de imersão e de realidade. Das pesquisas de 1964, passando por criar o sistema MUSE, em 1984, com 1125 linhas, e de batizá-lo de Hi-Vision, a NHK pesquisava uma nova resolução de televisão que permitisse dar ao telespectador a sensação de imersão, de ser envolvido e transportado pela imagem, a sensação de “estar presente”, algo como o público estava acostumado a ver no cinema. Concluiuse, nessas pesquisas, que além da quantidade de linhas na resolução da imagem, a distância do telespectador da tela e o seu ângulo de visão em relação à imagem eram também fundamentais, pois, quanto maior o campo de visão ocupado pela tela, em especial, alcançando a visão periférica, maior a sensação de imersão. (ALMAS, Almir. 2013. p. 90-94; 99-101)

Hoje, a NHK apresenta como principal pesquisa de uma televisão do futuro, a televisão em 8K Super Hi- Vision, com resolução de imagem de 33 megapixels e som em 22.2 multicanais. Pelo seu planejamento na linha do tempo, prevê-se que essa televisão esteja comercialmente disponível no país em 2020. Essa pesquisa é desenvolvida no Japão pelo STRL (NHK Science & Technology Research Laboratories), da NHK. Tecnicamente, a resolução da imagem em 8K Super Hi-Vision atinge uma resolução de imagem de até 33 megapixels, e é dezesseis vezes maior que a resolução da imagem de HDTV e quatro vezes maior que a imagem em 4K.

Isto é, enquanto a HDTV possui uma resolução de imagem de 1920 x 1080 pixels e de som em canais 5.1, no 4K de 3840 x 2160 pixels (ou o DCI 4K de 4096 x 2160 pixels) e som podendo chegar a 9.2 canais, no 8K, temse a resolução de imagem de 7680 x 4320 e som em canais de 22.2. Pode atingir um frame rate de até 120 Hz.

No pavilhão do Futuro a NHK apresentava a câmera Ikegami 8K utilizada pela emissora pública japonesa nos seus testes de captação

Durante a NAB Show 2015, em Las Vegas, Estados Unidos, fizemos uma entrevista com Shinya Takeuchi, engenheiro do Science & Technology Research Laboratories (STRL) da NHK, e ficamos sabendo um pouco mais sobre o projeto 8K. Antes da entrevista, fomos ver a demonstração de material gravado e editado em 8K, que a NHK exibia em seu estande. Na programação, além do material realizado no Brasil, durante a Copa do Mundo Brasil 2014, tinha também outros vídeos, dentre os quais uma linda apresentação do inovador grupo Japonês DRUM TAO, com Taikos (tambores tradicionais do Japão). Como já tínhamos visto a demonstração da transmissão pública na Copa do Mundo, no Rio de Janeiro, em junho do ano passado, parte desse material não foi inédito para nós. Inclusive, o tamanho da tela, nos parece, foi o mesmo. Sem sombra de dúvida, a sensação de imersão (o “Being There”) e de realidade é realmente forte. O som em 22.2 canais é surpreendente e ajuda bastante na construção dessa sensação.

Evidentemente, os jogos da Copa do Mundo FIFA Brasil 2014 impressiona bastante; mas o restante da programação, composta também pelos vídeos DRUM TAO’s Japanese Drumming Live, 8K a Journey into Space, The Beating Heart of Fuji e Tokyo Girls Collection Fashion Show 2015, impressiona. Em especial, a apresentação de Taiko e a Copa do Mundo são de uma beleza excepcional e de uma capacidade fenomenal para nos levar à imersão, tanto pela imagem, quanto pelo som.

O pavilhão do Futuro mostrava no estande da NHK o workflow de audio 22.2

Voltando à questão do planejamento dos próximos vinte anos, a NHK apresenta uma linha do tempo em que o ápice da sua pesquisa da transmissão em 8K deverá culminar com a transmissão 8K via Satélite das Olimpíadas de Tóquio, em 2020. E passando, nessa linha do tempo, pela transmissão 8K via Satélite da Copa do Mundo da FIFA Rússia, em 2018 e pelo início dos testes de transmissão 8K via satélite, em 2016.

Nessa linha há também outros marcos, desde o que mostra o início da pesquisa em sistema de vídeo em Ultra-High Definition ainda em 1995 (ano dos setenta anos da NHK, como mostramos no início deste artigo), como o da transmissão e apresentação pública de parte dos jogos da Copa do Mundo Brasil 2014 [em parceria com a Rede Globo de Televisão, Rede Nacional de Ensino e Pesquisa (RNP), Nippon Telegraph and Telephone (NTT) e apoio do Centro Brasileiro de Pesquisas Físicas (CBPF), como noticia nesta revista na edição Nº 144 de Agosto de 2014]. Os jogos do Brasil foram transmitidos para três pontos dentro do país (TV Globo, IBC/International Broadcast Center e FIFA Lounge) e para quatro pontos no Japão (Tokyo, Yokohama, Osaka e Tokushima). Além desses, destacam- se também os seguintes marcos(3):IBC 2014, em Amsterdã: primeira apresentação pública de vídeo em 8K, gravado com uma câmera 8k Super Hi-Vision na frequência de 120 Hz;

Shinya Takeuchi da Science & Technology Research Laboratories (STRL) da NHK na conferencia: “Super Hi-Vision Multimedia Broodcast Systems Based on ‘Hybridcast”, no dia 13 de abril de 2015, às 11h30, na sala LVCC Room S219

Teste de transmissão de 8K Super Hi-Vision em cadeia nacional de TV a Cabo, em maio de 2014;

Teste de transmissão terrestre em longa distância de 8K Super Hi-Vision, em janeiro de 2014;

Desenvolvimento do primeiro encoder em tempo real do HEVC para 8K Super Hi-Vision, em maio de 2013;

Inauguração do Forum NexTV (Next Generation Television & Broadcasting Promotion Forum [NexTV-F]), em maio de 2013;

Transmissão pública experimental em 8K Super Hi-Vision dos Jogos Olímpicos de Londres, para três pontos no Japão, quatro no Reino Unido e um nos Estados Unidos, em julho de 2012;

Transmissão experimental em 8K Super Hi-Vision em ondas terrestres, em maio de 2012;

Transmissão experimental de 8K Super Hi-Vision ao vivo em multicanal via satélite, em maio de 2009;

Transmissão do famoso programa da NHK “Kohaku Utagasen”, em 8K Super Hi-Vision com compressão em rede IP, de Tokyo a Osaka, em cooperação com a NTT e a NTT Communications, em dezembro de 2006;

O sistema de vídeo Ultra-High Definition com 4000 linhas e som em multicanal 22.2 passa a ser nomeado Super Hi-Vision, em 2004;

Primeira exibição de vídeo Ultra-High Definition é mostrado pela NHK no Science & Technology Research Laboratories Open House, em março de 2002.

Na entrevista com Shinya Takeuchi, tomamos mão de um paralelo entre as pesquisas com 8K Super Hi- Vision de agora e as pesquisas de TV de alta definição e TV Digital da NHK, recentemente. Perguntamos como a experiência anterior tem ajudado nas pesquisas atuais. Ele nos respondeu que, tecnicamente, podese dizer que as pesquisas têm muito a ver uma com a outra, porém, como são sistemas diferentes, cada um tem suas especificidades. Quando se começou a transmissão da Hi-Vision, por exemplo, começou-se por um canal de satélite da NHK, e posteriormente se passou à transmissão em canais terrestres. Com o 8K Super Hi-Vision também se começará com a transmissão via Satélite, e pretende-se que em 2020 as transmissões continuem via satélite, embora se pesquisem transmissões terrestres. O sistema preparado para as transmissões experimentais a partir de 2016 comprime o sinal de acordo com a norma da ARIB de “Transmission System for Advanced Wide Band Digital Satellite Broadcasting”, em um único transponder de satélite, utilizando o parâmetro 16APSK (a) (Amplitude and Phase-Shift Keying), a mais ou menos 100 Mbps, em codificação de compressão MPEG-H HEVC/H.265 (b), padronizado internacionalmente em 2013 pela ITU e ISSO/IEC. Planeja-se também o uso da padronização internacional MMT (c), numa banda 17 GHz para subida e de 12 GHz de descida.

Conversamos também no estande com outros técnicos da NHK que nos responderam sobre o som 22.2. Procuramos saber sobre os arranjos usados quando da gravação do som, para que se reproduza fielmente o esquema 22.2 canais. Segundo eles, nos sets dos microfones, usam-se três layers (ou três níveis), um na altura do ouvido, outro encima e outro embaixo. Porém, para cada conteúdo especificamente, os produtores e diretores, junto com os engenheiros, decidem a quantidade de microfones e a sua colocação. Costuma-se usar microfones normais, e, vez ou outra, microfones especiais.

O som também é um fator essencial para levar o telespectador a viver essa sensação de imersão e de realidade. Enquanto na HDTV o som esteja em 5.1 canais, o som do 8K Super Hi-Vision trabalha em 22.2 canais; o que provoca muito mais essa sensação. Sobre o desenvolvimento de equipamentos, como câmeras e gravadores, Shinya Takeuchi disse que no início das pesquisas a própria NHK desenvolveu os equipamentos, e que posteriormente empresas como a Hitachi, Ikegami e Astro Design, por exemplo, entraram no desenvolvimento desses equipamentos. Entendendo que na base da pesquisa está o objetivo de alcançar a sensação de imersão e de realidade, perguntamos a Shinya sobre qual a distância que o telespectador deveria estar da tela (ou qual a relação distância altura da tela) indicada para que essa sensação se estabeleça. Como a resolução da imagem em 8K Super Hi-Vision é dezesseis vezes maior que a resolução da imagem em Full HD, e com a HDTV a distância ideal é de três vezes a altura da tela, para o 8K Super Hi-Vision o ideal é de apenas 0,75 vezes a altura da tela. Embora, ressalva-se, Shinya tenha dito que não tinha esse dado de forma clara.

Segundo Shinya Takeuchi, além da NHK, ainda não há outra emissora no Japão experimentando o 8K Super Hi- Vision. A NHK é líder no experimento, sendo a primeira emissora a realizar esse tipo de pesquisa e de desenvolvimento de equipamentos e procedimentos. Segundo ele, espera-se que as outras emissoras japonesas, das redes privadas, que compõem o modelo televisivo japonês, venham a se integrar a essas pesquisas. Mais uma vez, fazemos aqui o paralelo com as pesquisas da HDTV. Sendo inicialmente uma pesquisa da NHK, as emissoras privadas começaram a fazer parte das transmissões apenas no processo final do desenvolvimento.

Também, a exemplo da pesquisa da HDTV, perguntamos a Shinya sobre a criação de alguma entidade no formato da antiga associação que foi criada para a HDTV, a HPA (Hi-Vision Promotion Association, criada em 1987, pelo MTP [Ministry of Post and Telecommunication], do Japão). Ele nos disse que para a pesquisa de 8K Super Hi-Vision foi criado em maio de 2013, o Fórum da NexTV (Next Generation Television & Broadcasting Promotion Forum [NexTV-F]), que é uma espécie de consórcio de empresas, com o objetivo de pesquisar a televisão do futuro. Veja também na linha do tempo mostrada acima.

Perguntado sobre qual o papel da NHK em relação ao 4K e de como se posiciona o 4K diante da pesquisa do 8K, Shinya disse que o objetivo principal da NHK é ir direto ao 8K. Não há interesse em desenvolver o 4K, pois o objetivo principal é desenvolver o 8K em parceria com empresas fabricantes de equipamentos.

E, segundo ele, um dos motivos para não dar atenção ao 4K é o custo, É muito caro desenvolver a tecnologia e, dessa forma, vale mais a pena partir direto para o 8K, como a NHK está fazendo.

Por fim, perguntando sobre quais conteúdos a NHK pretende produzir para o 8K, Shinya respondeu que a parte de conteúdo não é sua especialidade, mas que, como se pode ver pela programação apresentada, a NHK pretende investir em conteúdos como esportes, documentários de registros da natureza, música e também ficção. Por exemplo, um dos programas mais populares e de maior audiência do Japão, o “Kohaku Utagasen”, é gravado todo ano em 8K Super Hi-Vision.

Foi, inclusive, um dos marcos da pesquisa, em dezembro de 2006, como se vê na linha do tempo mostrada acima. Segundo ele, há uma colaboração estreita entre o laboratório de engenharia e de pesquisa tecnológica com o departamento de produção e direção da emissora. Primeiro o laboratório de engenharia e de pesquisa desenvolve a tecnologia e os equipamentos, e depois a produção e direção se incorporam ao desenvolvimento para a criação de conteúdo.

(1) ALMAS, Almir. Televisão Digital terrestre: sistemas, padrões e modelos. São Paulo: Alameda, 2013. p. 76-77.

(2) ALMAS, Almir. Televisão Digital terrestre: sistemas, padrões e modelos. São Paulo: Alameda, 2013. p. 76-77.

(3) Dados retirados de material gráfico distribuídos pela NHK em seu Stand, durante a NABShow 2015.

APSK (Amplitude and Phase-Shift Keying)

HEVC (High Eficiency Video Coding)

MMP (MPEG Media Transport)

Nº 151 – Junho 2015

“O OLHAR DOS ESPECIALISTAS DA SET”

O maravilhoso mundo da Super Alta Definição e as mudanças na TV

Especialmente desenhada para a Copa do Mundo 2014, a UM 4K da Globosat foi a primeira do tipo na América Latina

Muito temos escrito sobre Ultra Alta Definição 4K (UHD) e 8K Super Hi-Vision (SHV), inclusive o dizemos na edição anterior da Revista da SET, mas o tema não se esgota nem se esgotará tão depressa. A inovação tecnológica não para, e a corrida pela qualidade de imagem parece não ter fim, ou terá? Essa é uma das perguntas que os estudiosos do tema se fazem e que na humilde opinião de quem escreve, parece não ter fim.

De fato, com a introdução do 4K as transmissões esportivas na última Copa do Mundo realizada no Brasil coordenadas pela FIFA (Federação Internacional de Futebol), e as em 8K realizadas experimentalmente pela NHK, o conceito de transmissão esportiva mudou, e muito, não mudou só a qualidade, mudou a forma retórica de fazer e a parafernália necessária para levar a alguns poucos duas formas de captação de video altamente ricas em qualidade de imagem e imersão, mas também mudou a forma de gerar essas imagens.

Nesse marco, afirmamos que o discurso futebolístico é talvez, junto ao melodrama encarnado pela telenovela, o mais difundido na TV nos últimos anos. Ele sustenta emissoras de TV por todo o mundo e aos poucos se tem transformado em quase uma “commodity” que se espalhou nas últimas duas décadas ao redor do mundo. Assim, após mais de meio século de existência a TV aberta está mudando, e talvez não pela sua própria vontade, mas sim pelo advento de novas tecnologias e plataformas que permitem ao telespectador – termo que consideramos ultrapassado – usufruir de conteúdos audiovisuais em multiplataformas mediante sistemas de VoD (Video-on-Demand), OTT (Over-the-Top), FTH (Directto- Home) e plataformas de webTV. Na atualidade, o mundo “da bola”, um dos mais rentáveis até hoje para as emissoras de TV aberta e de TV paga, precisa encontrar novas formas de desfrutar do fenômeno para que este continue sendo fonte de receita e, com isso, de sustentação do modelo atual de negócio. Assim, na última Copa do Mundo Brasil 2014 realizada pela FIFA houve mudanças substanciais no discurso “futebolístico” e, com isso, do seu espetáculo, com a introdução da tecnologia 4K – 4 vezes HD (High Definition). A introdução desta tecnologia mudou a retórica das narrativas das transmissões de futebol e de como a FIFA “padronizou” o espetáculo.

Mudou a forma de fazer técnica e retoricamente, mudou o enquadramento, produto dos sensores CMOS que não permitem determinadas tomadas em um evento ao vivo, a quantidade de câmeras no campo – passando de 32 na transmissão broadcast oficial para apenas 13 na transmissão 4K e 5 na 8K – e, sobretudo, a forma como se conta a história do jogo.

O conceito de TV se está reinventando e o destino do discurso futebolístico televisado está mudando porque já não se pensa somente em TV aberta ou TV paga Premium, senão em novas plataformas e soluções que podem viabilizar o consumo deste discurso, até parece ser possível inferir que não só o discurso está mudando, mas também o espectador, que aos poucos se vai tranformando em um usuário de múltiplas plataformas de vídeo e não um mero “tele”spectador sentado em frente à TV.

Nesse campo, parece que a tendência é uma maior qualidade de imagem, menos câmeras em campo e uma nova forma de olhar, que talvez, segundo alguns dizem, se concretize com a implantação no formato em 8K, onde o fenômeno imersivo da imagem poderá ser ainda maior e fazer com que o discurso futebolístico possa voltar a ser contado como no início das transmissões esportivas, com apenas uma câmera.

Moura, F (2015) Novo Paradigma nas transmissões televisivas. A Copa do Mundo em 4K, XIV Congresso Internacional Ibercom 2015, 29 de março a 2 de abril, ECA/USP São Paulo

Nº 151 – Junho 2015

“O OLHAR DOS ESPECIALISTAS DA SET”

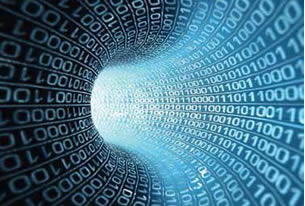

A televisão na nuvem ou “in the cloud”

Desde há algum tempo temos notado que os fundamentos e práticas da Tecnologia da Informação (TI) têm dominado o cenário da engenharia de televisão. Seguindo essa tendência, mais recentemente tem havido, no ambiente de broadcasting, menções crescentes sobre a contratação de serviços em nuvem.

Nesse ano de 2015, no entanto, houve um grande aprofundamento do assunto, em um painel do intitulado “Media Management in the cloud”, do Broadcast Engineering Conference organizada pela National Broadcasting Association (NAB) que se estendeu por 2 dias, reunindo clientes e fornecedores de serviços em nuvem, tratando dos avanços da segurança e confiabilidade do conteúdo.

Na última palestra do painel, conduzida por David Rosen, da Sony Professional Solutions, e tendo como participantes executivos de empresas tais como HBO e Turner Broadcasting, discutiu-se o futuro de serviços em nuvem, ficando muito clara a satisfação de quem dele já desfrutava. O futuro, portanto, descortina-se como promissor, crescente e irreversível.

Outra abordagem muito interessante e que parece ser bastante factível para a realidade brasileira é o conceito de “Hybrid Cloud”, abordado por Chris Chen, CTO da Prime Focus Technologies, onde parte do fluxo de trabalho vai para a nuvem, enquanto outras etapas ficam nas dependências da entidade editora, produtora ou exibidora do conteúdo. Ainda, segundo Chen, esse modelo operacional adequa-se perfeitamente em situações onde há vários trabalhos compartilhados por várias equipes situadas em diferentes geografias.

É digno de nota o fato de que quando se discutia, no referido painel, pontos críticos inerentes a serviços em nuvem, a questão relativa à confiabilidade das conexões de dados não era muito questionada, como acontece no Brasil. As preocupações maiores são relativas à disponibilidade de banda, custo e recursos para recuperação de desastres, enquanto que o grande benefício passa pela disponibilidade imediata de infraestrutura para edição, exibição ou qualquer outro fluxo.

Pudemos também constatar no ambiente de exibição de equipamentos (NABShow2015) que os serviços em nuvem não se restringiam apenas a debates sobre o futuro. A Imagine Communications (ex Harris Broadcast) alardeava o contrato de colaboração com a Disney/ABC Television Group na transição para uma arquitetura IP em nuvem, do processo de exibição de sua programação global.

E essa deve ser a tendência. Tradicionais fornecedores agregando ao portfólio de produtos os serviços em nuvem, serviços esses que atualmente são desempenhados por seus equipamentos nas centrais técnicas dos clientes. Ou seja, menos venda de equipamentos e mais venda de serviços.

Também, o fluxo de trabalho definido por software parece ser uma forte tendência. Nesse caso, todas as necessidades de codificação, decodificação, controle de qualidade etc., ou uma combinação dessas necessidades estão disponíveis em nuvem.

A Quantum, tradicional fornecedora de sistemas para gerenciamento de fluxo de trabalho e armazenamento de conteúdo, desde 2014 vem oferecendo, de forma bem estruturada, solução em nuvem para armazenamento de conteúdo, o que pode ser um primeiro passo para a adoção da tecnologia.

Nº 151 – Junho 2015

“O OLHAR DOS ESPECIALISTAS DA SET”

“Net Neutrality”

Há mais de uma década, no ano de 2003, Tim Wu, um professor da faculdade de direito da Universidade de Columbia, publicou um longo artigo1 no qual apresentou e analisou um problema em potencial para o ambiente aberto da Internet: a prática, por parte dos provedores de serviços de Internet, de administração discriminatória do tráfego dos diferentes pacotes de dados que trafegavam em suas redes.

Wu acreditava que tal prática era necessária para o gerenciamento e bom funcionamento das redes que integram a Internet, mas não poderia ser aplicada de modo a prejudicar seus usuários finais, os quais deveriam permanecer amparados por um princípio que o professor chamou de network neutrality.

Atualmente, a ideia cunhada e defendida por Tim Wu é mais conhecida pela forma abreviada net neutrality, literalmente a neutralidade da rede, e significa que todos os pacotes de dados que trafegam pela Internet devem ser tratados da mesma forma, sem qualquer discriminação baseada na sua origem, destino, aplicação, conteúdo ou distribuidor.

A grande característica da internet e provavelmente o motivo do seu enorme sucesso é exatamente o fato de ela existir num ambiente livre e inovador e é essa característica que muitos querem garantir que seja, no futuro, conservada e perpetuada.

Existe uma corrente que acredita que os interesses particulares dos provedores de serviços de Internet podem corrompê-la, distorcendo sua natureza livre, seu ambiente aberto e prejudicando seus usuários em todo o planeta.

Essa corrente acredita que somente uma regulação governamental dos serviços de acesso à Internet pode preservar e garantir a neutralidade da rede, zelando assim pelo interesse dos usuários, que seriam mantidos a salvo dos interesses dos provedores desses serviços.

Outros confiam que a Internet deve ser tratada como sempre foi, mantida longe dos atos regulatórios do governo e autorregulada pelas práticas do livre mercado.

Os provedores de serviços de Internet são proibidos de bloquear o acesso pelos usuários a qualquer conteúdo;Defendem que a Internet é, atualmente, o resultado de um ambiente aberto que foi, desde o seu surgimento, poupado dos mandos e desmandos dos governos e que ela sempre funcionou e continuará funcionando muito bem sem a interferência estatal. Nos Estados Unidos, os opositores à regulação contam com o apoio do poderoso lobby dos provedores de serviços de Internet (conhecidos pela sigla ISP – Internet Service Provider).

Nos últimos anos, e de forma mais intensa desde 2014, os Estados Unidos foram palco de uma acirrada disputa entre essas correntes opostas. Instaurou-se um debate público com um engajamento sem precedentes por parte das instituições, das empresas e do povo norte-americano. A questão sobre a qual todos se debruçavam era a seguinte: a imposição de uma regulação com o intuito de garantir e preservar a neutralidade da rede teria um impacto positivo ou negativo para os usuários da Internet?

Ao longo desse período de debates, a corrente a favor da regulação demonstrou-se esmagadoramente mais forte do que os opositores, enquanto agregava vozes de peso como as gigantes Amazon, Facebook, Google, Microsoft, Twitter, Netflix, Yahoo!, Ebay, LinkedIn e Mozilla; as ONGs Free Press e Electronic Frontier Foundation (EFF); o popular apresentador da HBO John Oliver, cujo vídeo em defesa da regulação, postado no Youtube, foi o mais assistido sobre o tema2; o próprio presidente norte-americano Barack Obama, que realizou um pronunciamento defendendo a adoção de regras rigorosas para a preservação da neutralidade de rede nos Estados Unidos; e uma larga maioria da opinião pública no país.

Os defensores da regulação da Internet nos Estados Unidos fizeram-se ouvir não somente por todas as mídias disponíveis, desde as mais tradicionais como o Washington Post, Wall Street Journal e New York Times, até as chamadas novas mídias como Twitter e Youtube, mas também foram ouvidos diretamente pela Federal Communications Comission (FCC), a autarquia do governo americano responsável por regular as atividades de comunicação em geral, incluindo radiodifusão, telecomunicações e a Internet.

Em meados de 2014, a FCC abriu um período de consulta pública para que todos os interessados enviassem seus comentários acerca das novas regras que seriam adotadas em prol da neutralidade de rede.

O resultado dessa consulta pública foi inédito: 3,7 milhões de comentários foram submetidos à agência reguladora. Segundo estimativas baseadas em 800 mil comentários enviados, menos de 1% eram claramente contrários à regulação3.

Após incessantes debates, com a participação expressiva da indústria, da sociedade civil e dos usuários de Internet em geral, a FCC aprovou suas novas normas sobre neutralidade da rede no dia 26 de fevereiro de 2015, consideradas uma grande vitória para os defensores da regulação. De forma muito resumida, a regulação dispõe que:

- Os provedores de serviços de Internet são proibidos de reduzir a velocidade de acesso dos usuários a qualquer conteúdo;

- Os provedores de serviços de Internet são proibidos de cobrar tarifas dos provedores de conteúdo para que seu conteúdo seja distribuído aos usuários de forma mais rápida (prática conhecida nos EUA como paid priorization);

- Os provedores de serviços de Internet são proibidos de realizar qualquer interferência irrazoável no tráfego de dados bem como gerar qualquer desvantagem aos usuários no tráfego de seus dados;

e - Os provedores de serviços de Internet são obrigados a adotar práticas transparentes em relação ao tratamento dos pacotes de dados que trafegam por suas redes.

Não obstante a publicação das referidas normas pela FCC, os provedores americanos de serviços de Internet ainda não deram por vencida sua batalha em prol de uma Internet sem regulação estatal. Liderados pela AT&T, os provedores já ingressaram com uma ação judicial na Circuit Court of Appeals do Distrito de Columbia, visando derrubar as normas aprovadas em fevereiro.

O Brasil também foi palco de vários questionamentos acerca da neutralidade de rede. Liderada pelo Deputado Federal Alessandro Molon, a aprovação do Marco Civil da Internet (PL 2.126/11) foi um produto inovador de uma consulta pública on-line e off-line e se tornou referência internacional. Ao longo do debate nacional, o princípio foi expressamente defendido por entidades como o Instituto Brasileiro de Defesa do Consumidor.

Com sua votação sendo consecutivamente adiada, o Projeto de Lei passou na Câmara dos Deputados e foi finalmente sancionado pela Presidente Dilma Rousseff em 23 de abril de 2014. Segundo o Deputado Molon, o Marco Civil seria uma “espécie de constituição da internet que estabelece os princípios, garantias, direitos e deveres dos usuários.”

Uma das inovações dessa lei foi a incorporação do conceito de neutralidade da rede, como forma de garantir a chamada “Internet livre”. Através dessa lei fica estabelecida a obrigatoriedade de um tratamento isonômico aos pacotes de dados em tráfego de rede.

Assim, as empresas não poderão discriminar o acesso por conteúdo que trafega na rede ou por usuários.

Em nenhuma hipótese, poderão as empresas priorizar determinados serviços ou aplicações em detrimento de outros. Algumas exceções ainda serão regulamentadas e a ANATEL e o CGI (Comitê Gestor da Internet no Brasil) serão consultados.

Além disso, o Marco Civil protege a privacidade de usuários e seus dados de acesso e estabelece a responsabilidade civil dos provedores. De acordo com a nova lei, os provedores poderão responder pelos danos causados com a divulgação de dados de terceiros sem as devidas autorizações.

Apesar de ainda carecer de regulamentação, o Marco Civil ingressou no cenário legislativo nacional como um importante primeiro passo na direção de uma Internet regulada, em que os direitos dos usuários sejam resguardados em lei e garantidos pelas autoridades públicas e em que os deveres das empresas sejam claramente definidos. Dentre suas normas, a neutralidade de rede ganhou destaque como um dos princípios fundamentais consagrados na lei.

O mesmo Tim Wu, citado no início deste artigo, que cunhou a ideia de neutralidade da rede em 2003, avaliou o texto do Marco Civil da Internet e aprovou a inclusão do mencionado princípio na legislação brasileira, declarando que “é muito importante para o futuro do Brasil, como um centro de inovação em internet (…), que o país aprove e respeite os princípios da neutralidade de rede.”4 Os usuários da Internet, em todo o mundo, ficam na expectativa de que as iniciativas de seus governos para a regulação da Internet garantam, efetivamente, a perpetuação de uma Internet livre, aberta e inovadora, mantendo-se no futuro como um instrumento de inigualável capacidade propulsora do desenvolvimento econômico, social, educacional e cultural para todos os povos e nações.

(1) WU, Tim, Network Neutrality, Broadband Discrimination. Journal of Telecommunications and High Technology Law, Vol. 2, p. 141, 2003. Disponível em SSRN: http://ssrn.com/abstract =388863 ou http://dx.doi.org/10.2139/ssrn.388863

(2) 9.147.552 visualizações até o dia 15 de maio de 2015. Disponível em: https://www.youtube.com/watch?v=fpbOEoRrHyU

(3) Estudo realizado pela Sunlight Foundation disponível em: http://sunlightfoundation.com/blog/2014/09/02/what-can-welearn-from-800000-public-comments-on-the-fccs-net-neutrality-plan/

(4) http://oglobo.globo.com/sociedade/tecnologia/tim-wu-pai-doconceito-de-neutralidade-de-rede-apoia-marco-civil-da-internetno-brasil-8695505

Nº 151 – Junho 2015

“O OLHAR DOS ESPECIALISTAS DA SET”

Receptores Inteligentes para AM para o século XXI

Um dos temas que cresceu bastante no número de palestras nesse ano na Broadcast Engineering Conference organizada pela National Broadcasting Association (NAB) foi a revitalização do Rádio AM, neste artigo explicamos como seria realizada essa revitalização e os principais tópicos que atravessam essa transformação

Nesta edição da NAB/2015 constatamos, pela participação maciça da radiodifusão e pela presença de diferentes setores que a cada ano se tornam próximos da radiodifusão, que a discussão fundamental tornou-se uma discussão de provedores de conteúdo (mídia, novas mídias e mídia social), telecomunicações e estratégias de negócios.

Não é nenhum absurdo supor que num futuro, que já começou, independentemente do conteúdo, da forma e do meio que esse conteúdo chegará às pessoas, a mobilidade terá prioridade na vida social.

Além disso, toda a estratégia de negócio se volta para a sociedade de consumo que se encontra nos grandes centros populacionais. Cada vez mais as soluções tecnológicas apresentadas buscam atender a massa de povos, grupos empresariais, religiosos, políticos, defesas nacionais e seguranças públicas, famílias e etc., etc. e etc., que vivem nos grandes centros.

Isso tem um preço, que vira uma busca sem fim e esbarra em dois grandes pontos, o acesso ao conteúdo ou serviço e o tráfego de dados de informações.

Esses dois pontos se tornam o gargalo desse futuro tecnológico. Sem resolvê-los, não poderemos aglutinar interesses e estratégias comerciais entre setores.

Por outro lado, nós teremos que criar estratégias de convivência entre setores até o período de steady-state e até que alguns setores sejam absorvidos por outros ou mesmo antes da absorção sejam abandonados no caminho.

Diferencias territoriais

A radiodifusão por seu caráter social, apesar de nos grandes centros ter-se a maior fonte de recursos, tem compromissos com toda a sociedade, em qualquer país.

Em países cujas dimensões territoriais são comparáveis a continentes, as soluções de acesso e de tráfego de informações devem ser mantidas vivas na mente daqueles que tem compromisso social.

Serviços que atendem pessoas que habitam em pontos muito distantes dos grandes centros, ou mesmo aqueles que são obrigados a viver em estradas levando produtos, cultura ou qualquer tipo de desenvolvimento, que não são poucos, devem ter a preocupação de não deixar de ter solução de continuidade, na forma de obter informações e entretenimento, promovendo a atualização de seus serviços e equipamentos.

O cuidado que a NAB/2015 demonstrou aos participantes, em chamar a sua atenção aos serviços que atendem países de grandes dimensões, nos alimenta e fortalece a perseverar em continuar falando desse tema, embora tenhamos outras direções.

Um dos temas que cresceu bastante no número de palestras nesse ano foi a Revitalização do Rádio AM.

O tema é recorrente.

Por que a NAB insiste no tema? Havia cinco palestras relacionadas com o tema. Será que a NAB está na contramão da história? Ou será que alguns temas da sua programação estão ‘dessintonizados’ da realidade que vivemos? Não é melhor ter 20 mil estações locais de FM do que carregar às costas 4 mil estações de AM e mais 10 a 12 mil de estações de FM?

Se analisarmos bem, não é o faturamento das emissoras que mantém acesa a chama da revitalização do rádio AM, também não pode ser que a NAB não sabe o que propor para tantas emissoras AM existentes nos EUA até o período de estabilização tecnológica. Se é que esse período virá algum dia.

Na verdade é uma lição para todos nós que ignoramos o número de estações de AM que há neste mundo, cerca de 20 mil estações e buscamos uma solução rápida por conveniência financeira. Nós queremos nos livrar daquilo que consideramos nossos fardos. Que não dá lucro, que já morreu e que ninguém ouve.

A palestra sobre os receptores inteligentes do AM para o século XXI foi uma palestra sugestiva, não foi uma palestra conclusiva e ponto final. Contudo, o projeto é bem elaborado e começa citando alguns problemas como os de largura de faixa de RF e de áudio para enfrentar as elevadas interferências causadas por interferências ambientais, em sua maioria causada pelo próprio homem.

Todas as possíveis fontes de interferência são citadas, mas a solução será como a do White Space, onde o rádio procurará seu espaço através de um projeto com a técnica do software defined radio, utilizando novo processamento de sinal digital.

Afinal, quem melhor utiliza o espectro, pois se com um receptor limitado de 2 a 3 kHz de largura de faixa é possível receber sinais de estações que estão a 2000 quilômetros. Desde a publicação da Consulta Pública da Federal Communications Comission (FCC), em 2014, a estratégia digital para o rádio tem mudado nos Estados Unidos.

Algumas propostas foram dirigidas por associações de engenharia e empresas. Outras partiram de propostas de fabricantes de chips que forneceram novas especificações para largura de faixa, relação sinal ruído, seletividade, sensibilidade, figura de ruído, separação de estéreo, são tantos parâmetros que se apresentam com necessidade de modificações que são novos receptores, nada a ver com o que conhecemos.

Espera-se que a indústria seja receptiva à nova proposta de receptores de rádio AM e com os resultados dos testes do rádio digital em AM, com transmissão full-digital, nos próximos anos tenhamos a volta da competitividade na qualidade de recepção do AM, frente a outras mídias digitais.

Pois sabemos que não há problemas de acesso e nem de tráfego numa transmissão AM.

Nº 151 – Junho 2015

“O OLHAR DOS ESPECIALISTAS DA SET”

O 4K esta aí!

O engenheiro do SBT passa revista aos principais temas abordados no Broadcast Engineering Conference com destaque para as transmissões em 4K na Correia do Sul, o ATSC 3.0 e o LDM (Layered Division Multiplexing)

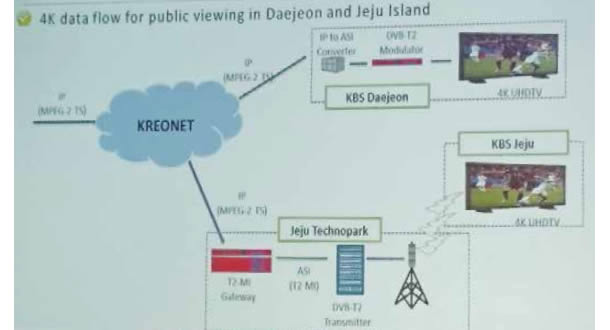

Na Broadcast Engineering Conference organizada pela National Broadcasting Association (NAB) três temas relevantes foram abordados durante as seções. Dentre eles o case apresentado pelo engenheiro e pesquisador Sansung Kin da emissora KBS (Korean Broadcasting System) que expôs o trabalho “The New Phase of Terrestrial UHD Service: Like 4K UHD Broadcasting via Terrestrial Channel” mostrando não apenas a captura das imagens com câmeras 4K, mas também o workflow IP até o processo de transmissão terrestre (Figura 1).

Figura 1 – Diagrama de captação até a recepção do conteúdo UHD realizado na Coreia

Na Coreia do Sul o sistema de transmissão adotado foi o DVB-T2 que utiliza 6 MHz de largura de banda. O sistema possibilita elevadas taxas de transmissão compatíveis com o 4K utilizando compressão HEVC (1).

Para a implantação do sistema UHD (Ultra High Definition) na Coreia do Sul foram programadas 4 fases.

Figura 2 – Sistema de recepção, produção e codificação UHD realizado durante a cobertura da copa do mundo

A primeira fase de testes ocorreu no fim do ano de 2012 utilizando HEVC no formato 4:2:0, 8 bits de amostragem e 30 q/s (quadros por segundo). No ano seguinte foram realizados novos testes utilizando 60 q/s ao invés de 120 q/s, em vista da emissora poder suportar o armazenamento utilizando 60 q/s e grande parte dos televisores deste país já utilizarem essa taxa.

Figura 2d – Diagrama IP realizado pela Kreonet até o sistema transmissor

Mediante a padronização da transmissão terrestre 4K a terceira fase de testes utilizou o mesmo formato, no entanto, com codificação de 10 bits. A Figura 2 apresenta o diagrama de captação até o sistema de transmissão. O fluxo de dados do conteúdo 4K produzido (MPEG2-TS) não comprimido foi encapsulado em IP e transmitido pela KREONET (2). Essas transmissões ocorreram ao vivo durante da Copa do Mundo realizada no Brasil e os jogos de vôlei realizados na Coreia do Sul em 2014.

Em complemento aos testes foram realizadas transmissões 4K utilizando SFN (Single Frequency Network – Rede de Frequência única). A última etapa terminará no fim deste ano e prevê a ampliação das áreas de cobertura e aumento da produção do conteúdo UHD.

Figura 3 – Diagrama Gamut comparando as recomendações 709 E 2020

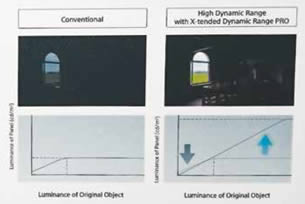

Acompanhando o 4K, outro tema abordado tanto no congresso como na feira foi o HDR (High Dynamic Range). Os atuais televisores de tela plana (LED, LCD, entre outros) apresentam limitação no brilho, contudo sendo melhores quando comparados aos antigos televisores de tubo (CRT) obedecendo a recomendação 709 (3).

Na prática o HDR apresenta maior contraste nas imagens, desse modo é possível obter mais detalhes tanto em áreas claras como escuras, proporcionando maior visibilidade e realidade do conteúdo seguindo a recomendação 2020 (4). A Figura 3 apresenta o diagrama Gamut comparando a faixa de cor entre as recomendações 709 e 2020.

Outro detalhe é que os televisores tradicionais apresentam um alcance dinâmico padrão (SDR – Standard Dynamic Range) graduado até 100 nits¹, enquanto o HDR pode produzir brilho de pelo menos 1000 nits².

A Figura 4 apresenta a comparação entre as duas tecnologias de televisores. É possível notar que o HDR apresenta maior contraste no conteúdo.

Figura 4 – Comparação entre um televisor SDR e HDR apresentado no estande da Sony

Nits ou candela por metro quadrado cd/m² é a unidade de medida da luminância que expressa a quantidade de luz emitida por uma superfície de 1 metro quadrado. Desde a captação através das câmeras até a recepção pelos televisores para realizar as transmissões em HDR são necessários equipamentos compatíveis com esta tecnologia de alto custo, como monitores profissionais 4K OLED HDR de 30 polegadas da SONY chegando até US$ 30.000.

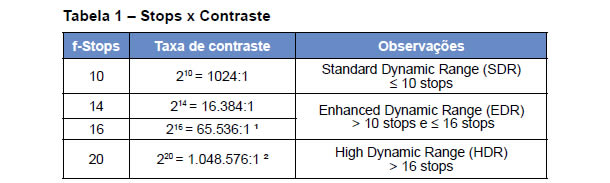

Aprofundando um pouco mais ao tema HDR o trabalho “12-bits is simply not enough for HDR vídeo!” exposto por Alan Chalmers (Figura 5), abordou suas características conforme Tabela 1 apresentando as etapas de compressão (H.264, HEVC ou VP9) do HDR. Primeiramente utilizando um único streaming contendo apenas o vídeo principal e dois streamings, composto do principal e de informações residuais que contém os detalhes perdidos.

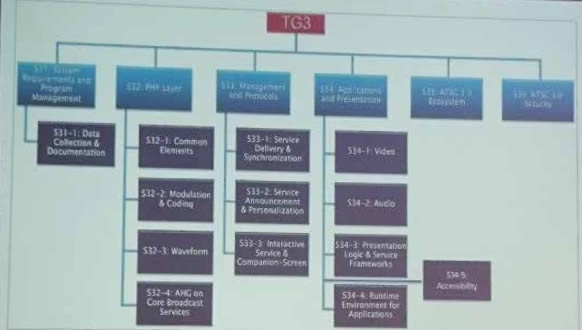

O terceiro tópico abordado no congresso foi o ATSC 3.0, apontado como a próxima geração da televisão digital. Durante o congresso foram apresentadas técnicas e estruturas que farão parte do novo sistema americano que visa sua padronização ainda este ano, algumas serão citadas neste artigo.Na sequência o estudo realizado entre um e dois streamings indicou que quando utilizado um streaming os detalhes podem ser perdidos mesmo utilizando 12bits.

No entanto, quando utilizado dois, o processo de codificação é mais complexo e os detalhes são preservados.

Acredito que nos próximos anos o HDR ganhará espaço em produções e principalmente em transmissões de eventos esportivos, proporcionando ao telespectador melhor visualização pelo fato de captar toda a faixa visível do olho. Com relação à técnica 12-bits é a melhor solução em curto prazo para início das produções utilizando HDR e estudos indicam existir a possibilidade de iniciar a transmissões utilizando dois streamings.

¹ 100.000:1 Normalmente é considerada a faixa visível que o olho pode ver na cena sem adaptação ² 1.000.000:1 Normalmente é considerada a faixa visível que o olho pode ver na cena com pequena adaptação (não perceptível)

O ATSC 3.0 propõe utilizar as técnicas mais eficientes e atender diversos cenários da engenharia de radiodifusão dentre eles: o uso flexível do espectro, robustez, mobilidade, UHD, serviços híbridos, multi-view/multi -screen, conteúdos 3D, imersão do áudio, acessibilidade, alerta de emergência, publicidade avançada / monetização, padrão mundial.

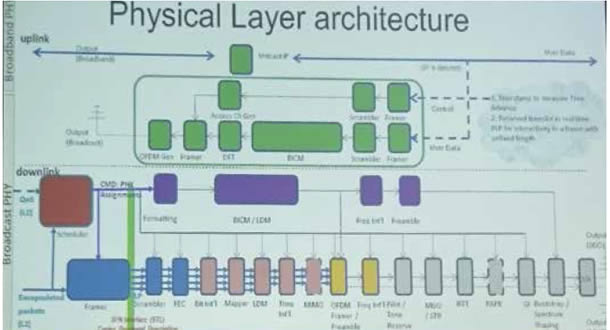

O grupo de estudos e desenvolvimento do ATSC 3.0 foi dividido em seis grupos, representado pela Figura 6. Em relação a estrutura física do ATSC 3.0, o sistema apresenta grande similaridade com o DVB-T2, como a utilização do codificador interno LDPC (Low Density Parity Check) bloco responsável por realizar a correção dos bits decodificados.Outro recurso é a inclusão da sinalização chamada de Bootstrap e no padrão europeu chamado de P1, sinalização responsável por realizar a detecção do canal, sincronismo, largura de banda, espaçamento entre subportadoras. A Figura 7 demonstra a estrutura proposta para o ATSC 3.0 contendo as técnicas já citadas.

Dentre as inovações está a ordem de modulação até 4096 QAM, o que proporciona maior taxa de transmissão comparada aos sistemas pré-existentes. Acompanhando as transmissões tipo MIMO (Multiple Input Multiple Output) apresentam mais de uma antena tanto na transmissão como na recepção do sinal, técnica também utilizada na telefonia móvel. O MIMO garante maior ganho no SNR (Signal Noise Ratio), comparado as tradicionais técnicas de transmissão como MISO, SISO (single).A técnica LDM (Layered Division Multiplexing) possibilita a transmissão de diferentes tipos de conteúdo ou mais informação utilizando a mesma largura de banda. Na prática ocorre a multiplexação do conteúdo em diferentes camadas, em que a camada superior apresenta um limiar SNR diferente da camada inferior.

No LDM a camada superior é indicada para transmissão para dispositivos móveis ou recepção indoor, no entanto, a camada inferior é indicada para altas taxas de transmissão e recepção fixa, a Figura 8 apresenta o conceito da técnica LDM.

Figura 5 – Apresentação “12-bits is simply not enough for HDR vídeo!” sobre HDR realizada por Alan Chalmers

Por fim o channel bonding é um novo recurso que possibilita a ligação dos canais, em que ocorre um aumento da banda de transmissão com canais adjacentes ou separados por n canais de RF. Desse modo cada largura de banda de um canal 6, 7 e 8 MHz apresentará uma banda total de 12, 14 e 16 MHz respectivamente, sendo que os canais poderiam apresentar diferentes parâmetros de transmissão.

O ATSC 3.0 pretende apresentar grande robustez, maior eficiência espectral (bits/s /Hz), aliada a estrutura dos pacotes ao universo IP.

A cada ano são abordadas novas tecnologias, já passamos pela era do 3D a qual de certo modo estagnou.

O 4K e a tecnologia IP já é uma realidade no mundo broadcast e a emissora NHK continua investindo todas suas fichas no UHD — 8K. Nas atuais circunstâncias existe uma disputa do UHD entre 4K e 8K, e o HDR veio para reforçar a permanência do sistema 4K descartando um eventual salto do HD para o 8K.

Já do ponto de vista das transmissões terrestres o futuro se resume ao ATSC 3.0, o qual promete atender todas as necessidades atuais abrangendo o universo IP e com grande possibilidade de vir a se tornar um novo padrão mundial.

Sabemos que os avanços tecnológicos são frenéticos, porém sempre atrelados ao custo que retardam sua implantação em nosso país. No fim do ano de 2015 o Brasil iniciará o primeiro passo para uma possível entrada das novas tecnologias com o desligamento do sinal analógico na cidade de Rio Verde/GO.

Os atuais projetos de engenharia de radiodifusão devem ser minimamente estudados, pois possuímos uma quantidade enorme de diferentes tipos de soluções e tendências de mercado. Caberá ao radiodifusor definir quando e em qual direção dar o segundo passo para que o projeto possa se manter viável para os próximos anos.

Figura 6 – Divisão dos grupos do ATSC 3.0

Figura 7 – Estrutura da camada física do ATSC 3.0

Figura 8 – Conceito básico de transmissão realizada por camadas

(1) P. G. Esperante, C. Akamine, G. Bedicks, R. Franco, “ANÁLISE DE DESEMPENHO DO SISTEMA DVB-T2 PARA TRANSMISSÃO DE 4K (UHD) USANDO 6 MHZ DE BANDA,” Revista de Radiodifusão, v.08, no.09, p. 10 – 15, 2014

(2) Disponível em: < http://www.kreonet.net/e_introduce01 >

(3) Disponível em: < https://www.itu.int/dms_pubrec/itu-r/rec/bt/ R-REC-BT.2020-1-201406-I!!PDF-E.pdf >

(4) Disponível em: < http://www.itu.int/dms_pubrec/itu-r/rec/bt/ R-REC-BT.709-5-200204-I!!PDF-E.pdf >